Web-corpusen Ataria: Elhuyar I+Gk egindako euskarazko webeko testuen biltegi erraldoia

- (Elhuyar aldizkariko 2013ko martxoko zenbakian argitaratutako artikuluaren jatorrizko extended bertsioa)

Hizkuntza batentzat oso garrantzitsua da testu-corpusak edukitzea (azterketa linguistikoak egiteko balio duten testu-bildumak). Hizkuntzalaritza-ikerketetarako, edo hizkuntza-estandarizazioan erabakiak hartzeko datuak lortzeko ezinbestekoak dira. Eta oso baliagarriak dira testu sorkuntzan edo itzulpengintzan ere: hiztegietan agertu ez edo adibide nahikorik ez duten hitzak nola erabili edo nola itzuli izan diren argitu diezagukete.

Baina, horrez gain, corpusek berebiziko garrantzia dute hizkuntza-teknologien munduan. Gaur egungo telefono mugikor adimendunek ekartzen duten ahots-ezagutzako sistemetan, adibidez, corpusak erabiltzen dira guztiz ongi ulertu ez den hitz bat asmatzen saiatzeko, aukeren artean testuinguru horretan probableena zein den corpusetan begiratuta; edo itzulpen automatikoko sistemek, esaterako, corpus paraleloak (elkarren itzulpen diren testuez osatutako corpusak) erabiltzen dituzte ikasteko, 2009ko azaroko zenbakian kontatzen genizuenez.

Zenbat eta corpus handiagoak, hobe

Artikulu hartan bertan azpimarratzen genuen corpus hauek zenbat eta handiagoak izan hobe dela. Hitz arraro baten erabilera kontsultatzeko, agerpen ezberdin gehiago, edo agertzeko aukera gehiago egongo dira corpusa handiagoa bada. Itzulpen automatikorako ere tamaina ahalik eta handieneko corpusak behar dira; horregatik da erreferentzia Google hizkuntza askotako itzulpen automatikoan, bilatzailerako indexatzen dituen testuekin corpus paralelo ikaragarriak osatzen dituelako.

Beste arlo askotan bezala, corpusenean ere baliabide gehiagoko beste hizkuntza batzuen oso atzetik dabil euskara, bai tamainan, bai denboran. Errepara diezaiogun ingelesaren egoerari: corpusgintza modernoaren abiapuntutzat jotzen den ingelesezko Brown corpusa 1964an sortu zen eta milioi bat hitz zituen; 100 milioi hitzeko British National Corpus 1995ekoa da; eta gaur egun, badaude ingelesezko milaka milioi hitzeko corpusak. Ingelesa barne hartzen duten corpus paraleloei dagokienez, Googlek 2005ean abiatutako itzulpen automatikoko sistema 200.000 milioi hitzeko corpus baten gainean entrenatu zen.

Euskaraz, aldiz, lehen corpusa (Euskaltzaindiaren Orotariko Euskal Hiztegiaren testu-corpusa) 1984an egin zen eta 4,6 milioi hitz ditu. Euskaltzaindiak berak egindako XX. Mendeko Euskararen Corpus Estatistikoa 2002an amaitu zen, 6 milioi hitzekin. Elhuyar Fundazioak eta Euskal Herriko Unibertsitateko IXA Taldeak Zientzia eta Teknologiaren Corpusa atera zuten 2006an, 9 milioi hitzekoa. EHUk ere urte horretan egin zuen Ereduzko Prosa Gaur deituriko corpusa, gaur egun 25,1 milioi hitzez osatua. Euskaltzaindiaren Lexikoaren Behatokia 2010ean abiarazi zen, eta egun 26,5 milioi hitz ditu. Corpus paraleloei dagokienez, itzulpen-enpresek dituzte ziurrenik horrelako handienak euren itzulpen-memorietan. Baina publikoarentzat eskuragarri eta hizkuntza-teknologietan erabiltzeko moduan oso gutxi daude; erakunde publiko (HAEEren Itzulpen Zerbitzu Ofiziala, Gipuzkoako Foru Aldundia, Bizkaiko Foru Aldundia...) edo bokazio sozialeko elkarte (EIZIE, Librezale) batzuetako itzulpen-zerbitzuen itzulpen-memoriak eta Eroskiren Consumer aldizkariko corpusa dira erreferentzia bakarrak, baina denak 5 milioi hitzen azpitik daude.

Konponbidea, weba

Arazo hori konpontzeko errezeta Adam Kilgarriff corpusetan adituak ematen zuen lehen aipatutako artikuluan: weba da corpus handiak modu erraz, merke eta azkarrean osatzeko modurik onena. Izan ere, ingelesezko aipatu ditugun azken urteotako corpus erraldoi horiek ere horrela osatu dira, ikusita corpusak era klasikoan osatzea (argitaletxeetara edo komunikabideetara joz) askoz garestiago eta neketsuagoa dela.

Corpusak webetik automatikoki osatzeak baditu bere aurkakoak ere. Haien objekzio nagusia da bertan kalitate eskaseko testu asko aurki daitezkeela. Baina beste ikuspegi batetik ikusita, hori da gaur egungo hizkuntzaren erabilera erreala, eta hori aztertzeko sortu ziren corpusak. Gainera, baliabide askoz gehiago dituzten hizkuntzek webera jo badute, euskararentzat ere hori da bidea atzean gelditu nahi ez badu.

Euskarazko Web-corpusen Ataria

Elhuyar Fundazioko hizkuntza-teknologien I+G taldekook badaramatzagu urte batzuk web-corpusen —hau da, webeko testuekin metodo automatikoak erabiliz eraikitako corpusen— arloa jorratzen. Mota askotako corpusak biltzeko metodoak landu ditugu: euskarazko corpus espezializatuak (jakintza-arlo jakin bateko testuz osatuak), corpus eleaniztun konparagarriak (jakintza-arlo bereko testuz osatuak), corpus paraleloak (elkarren itzulpen diren testuz osatuak), corpus orokor erraldoiak... Horrelakoak egiteko, beharrezkoa da hizkuntza-teknologietako beste teknika batzuk garatzea: bilatzaileen APIetatik hitz jakin batzuk dituzten web-orriak eskuratzekoak, testu baten hizkuntza ezagutzekoak, testu errepikatuak edo oso antzekoak detektatzekoak, web-orriak garbitzekoak (oinak, goiburuak, nabigazio-menuak, copyright-oharrak eta horrelakoak kentzeko eta testuaz soilik gelditzeko), spama apartatzekoak, testu baten jakintza-arloa detektatzekoak, itzulpenak ezagutzekoak...

Tresna horien bidez, aipatutako mota horietako guztietako corpus asko osatu ditugu. Eta orain, corpus horietako batzuk on line jarri ditugu Web-corpusen Atarian: 125 milioi hitzeko euskarazko corpus orokor handi bat (mota horretako orain arteko handiena zen, alde handiz; geroztik atera da handiago bat, EHUren Egungo Testuen Corpusa) eta 18 milioi hitzeko euskara-gaztelania corpus paralelo bat (corpus paralelo publikoen artean handiena). Corpus horien gainean hainbat bilaketa-mota egitea ahalbidetzen da webgunean. Lema edo forma jakin bat edo haien hasiera edo bukaera emanda galde daitezke, gehienez 5 hitzeko distantziara dauden hiru hitz arterainoko konbinaziotan. Paraleloan bi hitz arterainoko konbinazioak galde daitezke, baina hizkuntza batean, bestean edo bietan izan daitezela eska daiteke. Oso baliagarriak dira, biak, hitzak nola erabili edo itzuli izan diren ikusteko.

Horrez gain, corpus elebakarraren gainean teknika linguistiko eta estatistikoak aplikatuta, gehien erabiltzen diren hiru motatako konbinazioak kalkulatu dira (izen-izen, izen-aditz eta izen-adjektibo) eta kontsultagai jarri da. Hala, sistemari galdetu diezaiokegu hitz jakin bat zein aditzekin konbinatu ohi den, edo zein adjektiborekin, eta abar.

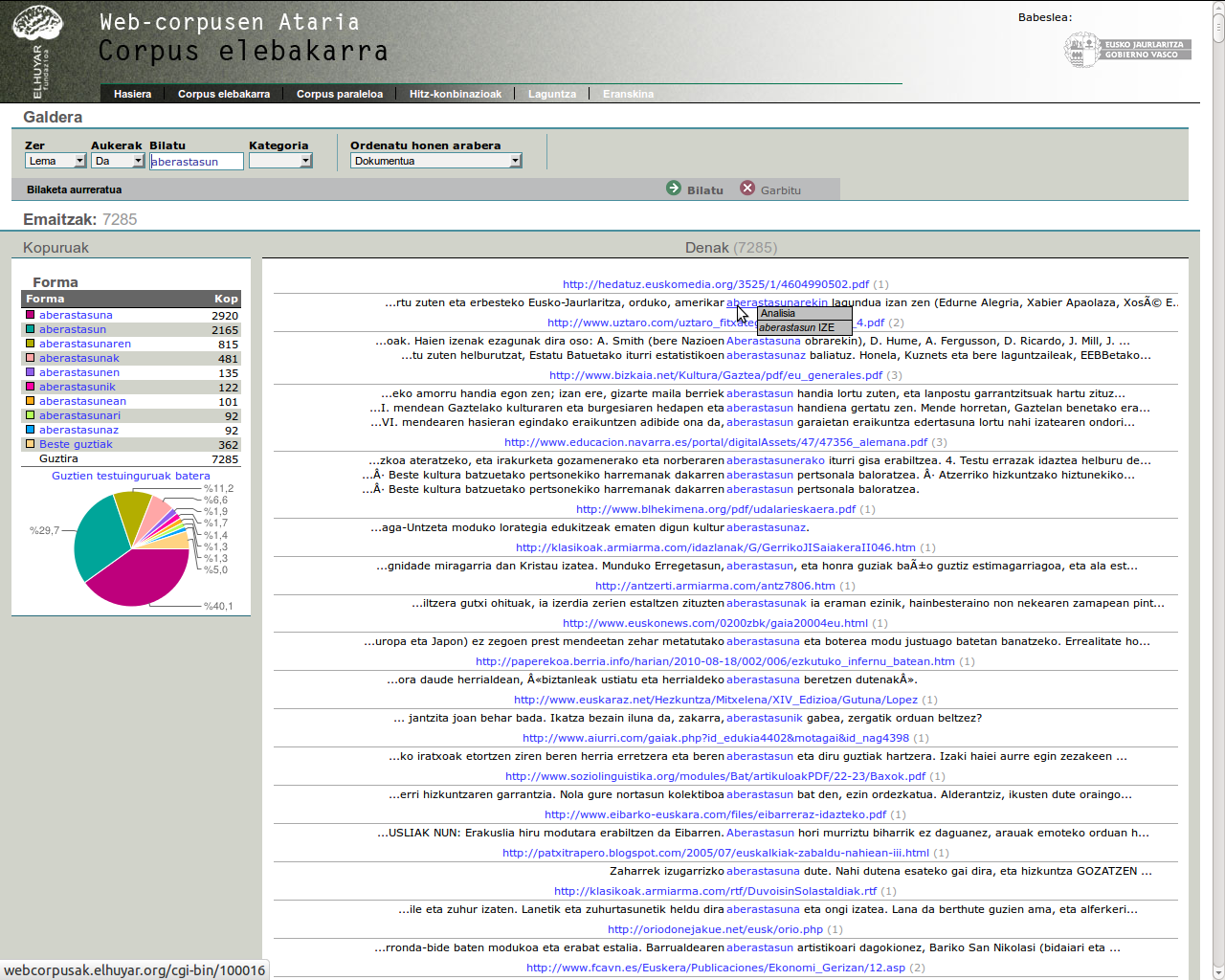

Web-corpus elebakarra

Corpus elebakarraren kontsulta-interfazea. Irudia: Elhuyar I+G

Bildu eta online jarri dugun web-corpus elebakarra euskarazko web-corpus bat da, 124.625.420 testu-hitz dituena. Interneten dauden mota eta arlo guztietako testuak biltzen ditu, eta gaur arte eratu den euskarazko corpusik handiena da. Linguistikoki etiketatuta dago.

Esan bezala, web-corpus hau guztiz automatikoki eratu da, Elhuyar Fundazioaren Hizkuntza eta Teknologia unitateko I+G taldeak garatutako teknologiak erabilita. Web-corpusa biltzeko tresnak ondoko gauzak egiten ditu:

- Interneteko euskarazko orriak lokalizatu

- Orri ez-egokiak iragazi

- Orri errepikatuak edo ia berdinak ezabatu

- Orritik edukizkoak ez diren atalak kendu (izenburuak, menuak, nabigazio-aukerak, oin-oharrak), testu nagusia baino ez corpuseratzeko.

Corpusaren osaera dela eta, 6.202 domeinutako 82.542 dokumentu ditu. Web-corpusen webguneko eranskina (elebakarra) atalean, domeinuen zerrenda eta bakoitzetik corpuseratutako dokumentuen eta hitzen kopuruak kontsulta daitezke.

Bilketa-metodoari buruz gehiago jakin nahi izanez gero, bibliografian aipatzen den [Leturia, 2012] artikulura jo dezakezu.

Webgune honetan kontsultagai jartzeko, testu guztiak linguistikoki prozesatu eta etiketatu dira. Horretarako, Euskal Herriko Unibertsitateko IXA taldeak garatutako Eustagger etiketatzailea erabili da. Tresna horrek testu-hitz edo token bakoitzari analisi linguistiko bat edo batzuk esleitzen dizkio, eta, atal honetako kontsulta antolatzeko, analisi bakoitzetik lema- eta kategoria-etiketak erabili dira (hitz-konbinazioen atalean eskaintzen den bigrama-erauzketa egiteko eta prozesatzeko, bi horiez gain, kasu- eta mugatasun-etiketak ere erabili dira). Informazio horren bidez, hitzak, beren lema, forma edo kategoriaren arabera bila daitezke. Hori ez ezik, lema edo forma batetik halako distantziara forma, lema edo kategoria jakin bateko hitzak dauden ere kontsulta daiteke. Hainbat aukera daude emaitzak ordenatzeko, eta datu estatistikoak aukeratzeko (ikus webguneko laguntza).

Web-corpus paraleloa

Corpus paraleloaren kontsulta-interfazea. Irudia: Elhuyar I+G

Atari honetan kontsultagai dagoen bigarren corpusa euskara-gaztelania corpus paraleloa da. Corpus hau automatikoki osatu da, Elhuyar Fundazioaren Hizkuntza eta Teknologia unitateko I+G taldeak garatutako PaCo2 [San Vicente & Manterola, 2012] tresna erabiliz. Tresna horrek erabiltzaileak aukeratutako bi hizkuntzetan eduki elebiduna duten domeinuak bilatzen ditu Interneten, eta domeinu horietatik elkarren itzulpen diren esaldiak erauzten ditu. 1. taulak corpusaren tamainaren inguruko datuak azaltzen ditu.

| eu | es | guztira | |

|---|---|---|---|

| Dokumentuak | 87.253 | 87.253 | 174.506 |

| Corpus gordinak (dokumentu-mailako parekatzea) | 34.902.457 | 42.183.563 | 77.086.020 |

| Segmentuak (esaldi-mailako parekatzea) | - | - | 659.630 |

| Hitzak (esaldi-mailako parekatzea) | 7.891.104 | 10.862.509 | 18.753.613 |

Corpus paraleloaren datu orokorrak

85 domeinutako testuak bildu dira corpusera. Web-corpusen webguneko eranskina (paraleloa) atalean, domeinuen zerrenda eta bakoitzetik corpuseratutako dokumentuen eta hitzen kopuruak kontsulta daitezke.

Gerora, corpusa hazten joango dela aurreikusten dugu. Une honetan, guk dakigula, automatikoki sortutako euskara-gaztelania corpus paralelo elebidunik handiena da.

Bildutako dokumentu elebidunak esaldi-mailan parekatzeko eta segmentuak sortzeko, Hunalign tresna erabili dugu. Ondoren, corpusa linguistikoki prozesatu da, eta etiketatuta dago. Corpus elebakarrean bezala, Euskal Herriko Unibertsitateko IXA taldeak garatutako Eustagger tresna erabili da euskarazko etiketatze linguistikoa egiteko. Gaztelaniazko testuak TreeTagger etiketatzailearen bidez prozesatu dira. Testuko hitz bakoitzari esleitutako informazio linguistikoari esker, corpusaren kontsulta-interfazean lema eta kategoriaren araberako hainbat bilaketa-mota egin daitezke (ikus webguneko laguntza).

Esan beharra dago bilketa automatikoa izateak abantaila argiak dituela, baina arazoak ere bai. Batetik, corpus hau eskuz biltzeak eskatuko lukeen denborak eta ahaleginak bideraezina egingo lukete proiektua. Bestetik, prozesu automatikoa izateak berekin dakar amaierako corpusaren kalitatea optimoa edo erabatekoa ez izatea. Izan ere, ezin dugu bermatu lortutako segmentu guztiak, hau da, esaldi guztien parekatzea, zuzenak direnik. Hainbat arrazoi daude horretarako: dokumentu batzuek itzulpen partzialak besterik ez dituzte, zenbait dokumentu paralelo gisa aurkezten diren arren, hizkuntza batean eta bestean agertzen den edukia ez da berdina... Bestetik, parekatze automatikoa egiten duten tresnen doitasuna ez da % 100koa. Nolanahi ere, gure corpus paraleloak eskaintzen dituen segmentuetatik % 90 zuzenak dira, hau da, elkarren itzulpen diren esaldiak dituzte. Une honetan, bozka-sistema bat lantzen ari gara, erabiltzaileak segmentu bat zuzena ala okerra den adierazteko aukera izan dezan. Horretara, corpusaren kalitatea hobetuz joango da.

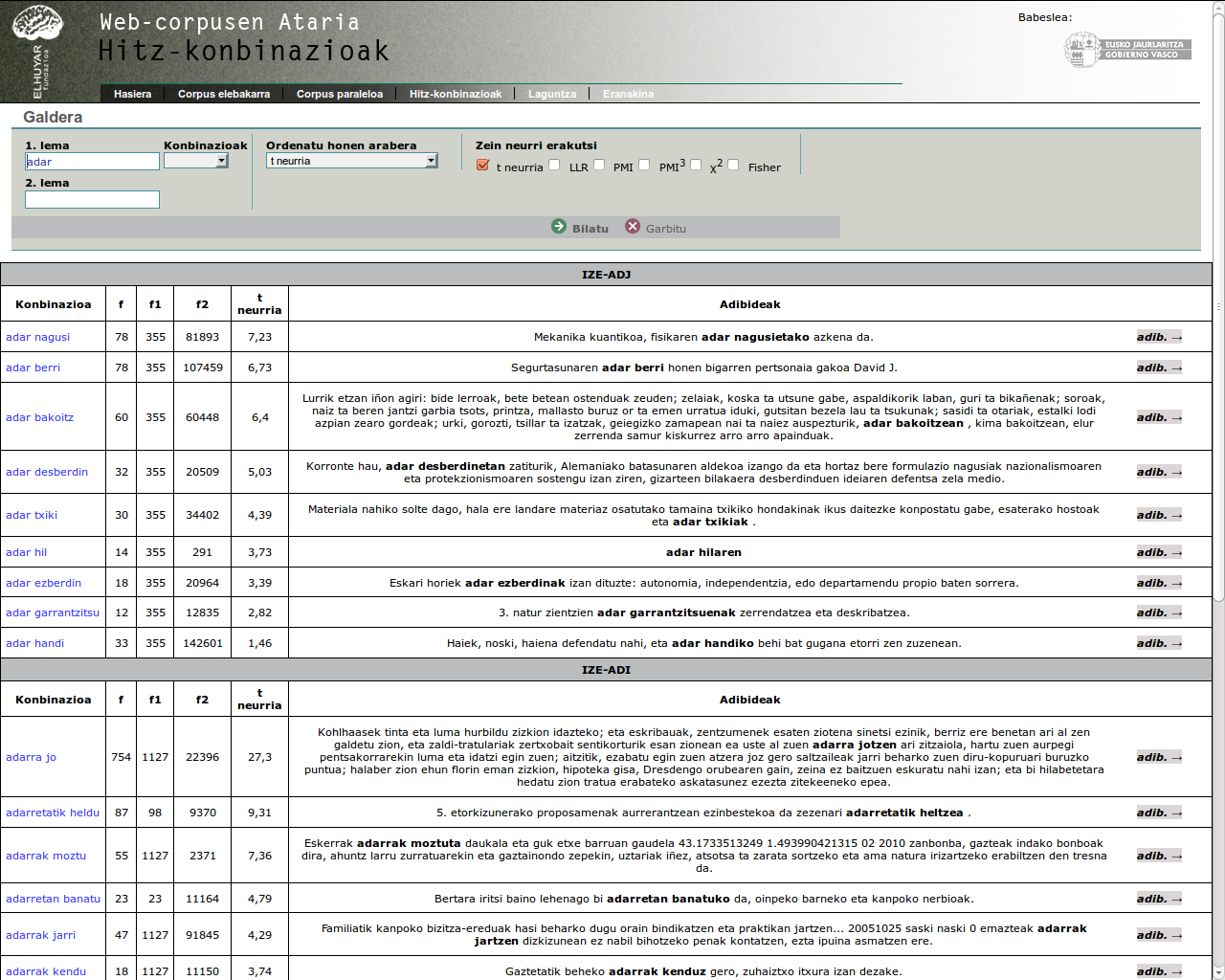

Hitz-konbinazioak

Hitz-konbinazioen kontsulta-adibidea. Irudia: Elhuyar I+G

Euskarazko web-corpus elebakarretik hiru eratako hitz-konbinazioak erauzi dira, automatikoki: izen+aditz, izen+izen eta izen+izenondo. Fraseologia konputazionaleko lan honetan erabilitako metodologia Elhuyar Fundazioaren Hizkuntza eta Teknologia unitateko I+G taldean diseinatu eta inplementatu da, Euskal Herriko Unibertsitateko IXA taldeko Iñaki Alegria lankide izanik [Gurrutxaga & Alegria, 2011]. Eustagger bidez prozesatutako web-corpus elebakar etiketatutik abiatuta egin dugu lan, eta, hortik aurrerako urratsetako batzuetan, erabilera libreko bi tresna erabili ditugu: Ted Pedersenen Ngram Statistics Package (NSP), bigrama-sorkuntzarako; eta Stefan Everten UCS toolkit, elkartze-neurri estatistikoak kalkulatzeko. Metodologiaren eta ebaluazioaren informazio zehatza du eskura erabiltzaileak bibliografian erreferentziatzen den artikuluan.

Hona hemen aipatu hiru konbinazio-motetako adibide batzuk:

- izen+aditz konbinazioak: gerrikoa estutu, adarretatik heldu, zubiak eraiki, loa galdu, atentzioa eman, adostasuna lortu, aktari erantsi, kalitateaz arduratu, egunkaria irakurri...

- izen+izen konbinazioak: arrain-sarda, mahai-jolas, elur-maluta, eguzki-haize, administrazio-kontseilu, energia-eraginkortasun, liburutegi-zerbitzu...

- izen+izenondo konbinazioak: ardi beltz, aita santu, zulo beltz, ardo ondu, haize fin, aldapa piko, lagun min, xedapen gehigarri, erregai fosil, nobela historiko, liburu interesgarri, partikula kargatu...

Horiek aztertuta, argi ikus daiteke erauzitako konbinazioak edo bigramak ez direla denak idiomatikotasun-maila berekoak: batzuk esapide idiomatikoak (edo lokuzioak) dira, beste batzuk kolokazioak, eta, azkenik, konbinazio libreak ere badaude. Egiten ari garen lanaren helburua da erauzitako konbinazioak idiomatikotasunaren arabera ordenatzeko teknikak garatzea. Izan ere, erabiltzailearentzat esapide idiomatikoak (gerrikoa estutu, adarretatik heldu, zubiak eraiki, aita santu) eta kolokazioak (atentzioa eman, arrain-sarda, lagun min) izaten dira interes handienekoak. izen+izen eta izen+izenondo konbinazioen kasuan, termino teknikoak ere erauzten dira, horietako batzuk idiomatikotasun-maila nabaria dutenak (eguzki-haize, zulo beltz).

Bada, lehen urrats honetan, bigramaren osagaien agerkidetzaren neurketa izan da idiomatikotasuna karakterizatzeko bidea. Egin dugun ikerketan, independenteki eskuz landutako erreferentzia bat erabili da ebaluaziorako, eta emaitza onenak t neurria (t-score) delakoak lortu ditu. Dena den, kontsulta-interfazean, erabiltzaileak, t neurriaz eta maiztasun absolutuaz gain, beste bost neurri estatistiko ditu aukeran, datuak bistaratzeko eta bigramak ordenatzeko.

Kontsulta-interfazeak eskaintzen dituen aukeren berri jakiteko, ikus webguneko laguntza.

Erabilera

Egia da jende gehienak ez duela ohiturarik corpusak erabiltzeko, aipatu ditugun hizkuntzaren espezialistak edo hizkuntza lan-tresnatzat duen jendea dira batez ere corpusen erabiltzaile. Jende gehienak hiztegiak erabiltzen ditu… Baina hiztegietan zerbait ez dagoenean, corpus hauek oso baliagarriak suerta dakizkieke; existitzen direla jakin behar, eta horiek erabiltzeko ohitura hartu behar...

Gainera, corpusek badituzte ezberdintasunak hiztegiekiko. Batetik, hiztegiek helburu preskriptibo edo arauemailea izaten dute; corpusek, aldiz, deskriptiboa. Honek esan nahi du corpusetan hizkuntza nola erabili izan den ikus daitekeela, eta ez soilik nola erabili beharko litzatekeen. Bestetik, hiztegiak egiteak kostu bat dauka eta mugatuak dira halabeharrez, hitz-kopuru zehatz bat eta adibide-kopuru mugatu bat dute soilik. Corpusetan, nahiko handiak izanik, hitz askoz gehiago ager daitezke eta erabilera-adibide gehiago.

Gainera, web-corpus hauek berezitasun batzuk dituzte beste corpusekiko: hain handiak izanik, aukera handiagoa dago beste corpusetan ez dauden hitzak aurkitzeko; hitz berriak ere aurki daitezke, weba etengabe eguneratzen baita; eta webeko erabilera informalaren (blogak, foroak...) berri ere ematen dute, ez soilik argitaletxe edo komunikabideak bezalako iturri editatuenak.

Edonola ere, nahiz eta jende askok zuzenean corpus hauek (edo beste edozein corpus) ez erabili, corpus hauei eta berauek biltzeko garatutako teknologiei esker etorkizunean garatuko diren hizkuntza-teknologiak (ahots-ezagutza, itzulpen automatikoa...) ziur erabiliko direla.

Web-corpusen Atariaren argitaratzea jauzi kualitatibo bat da, lehen aldia baita webetik automatikoki erauzitako corpusak publikoaren eskura jartzen direna, eta baita kuantitatiboa ere, corpusen tamainan aurrerakuntza esanguratsua baita. Koldo Mitxelenak zioen euskararen benetako misterioa ez dela jatorria, iraupena baizik. Misterio handiagoa da etorkizunean iraungo ote duen. Guk ez dugu horren erantzunik, baina iraungo badu zalantzarik gabe hizkuntza-teknologietan presente egon behar du euskarak. Web-corpusen Atariarekin norabide horretan beste pausu bat eman dugula sinetsita gaude Elhuyarren.

Bibliografia

- Leturia, Igor (2012). “Evaluating different methods for automatically collecting large general corpora for Basque from the web”. In Proceedings of the 24th International Conference on Computational Linguistics – CoLing 2012. Mumbai, India.

- San Vicente, Iñaki & Iker Manterola (2012). “PaCo2: A Fully Automated tool for gathering Parallel Corpora from the Web”. In Proceedings of the 8th international conference on Language Resources and Evaluation, LREC’12. 23-25 May, Istanbul, Turkia.

- Gurrutxaga, Antton & Iñaki Alegria (2011). “Automatic extraction of NV expressions in Basque: basic issues on cooccurrence techniques”.. In Proceedings of the Workshop on Multiword Expressions: from Parsing and Generation to the Real World (MWE 2011). ACL/HLT conference. Portland, AEB.